Gradient Descent

Review

前面预测宝可梦cp值的例子里,已经初步介绍了Gradient Descent的用法:

In step 3, we have to solve the following optimization problem:

L : loss function

假设

随机选取一组起始的参数:Randomly start at

计算

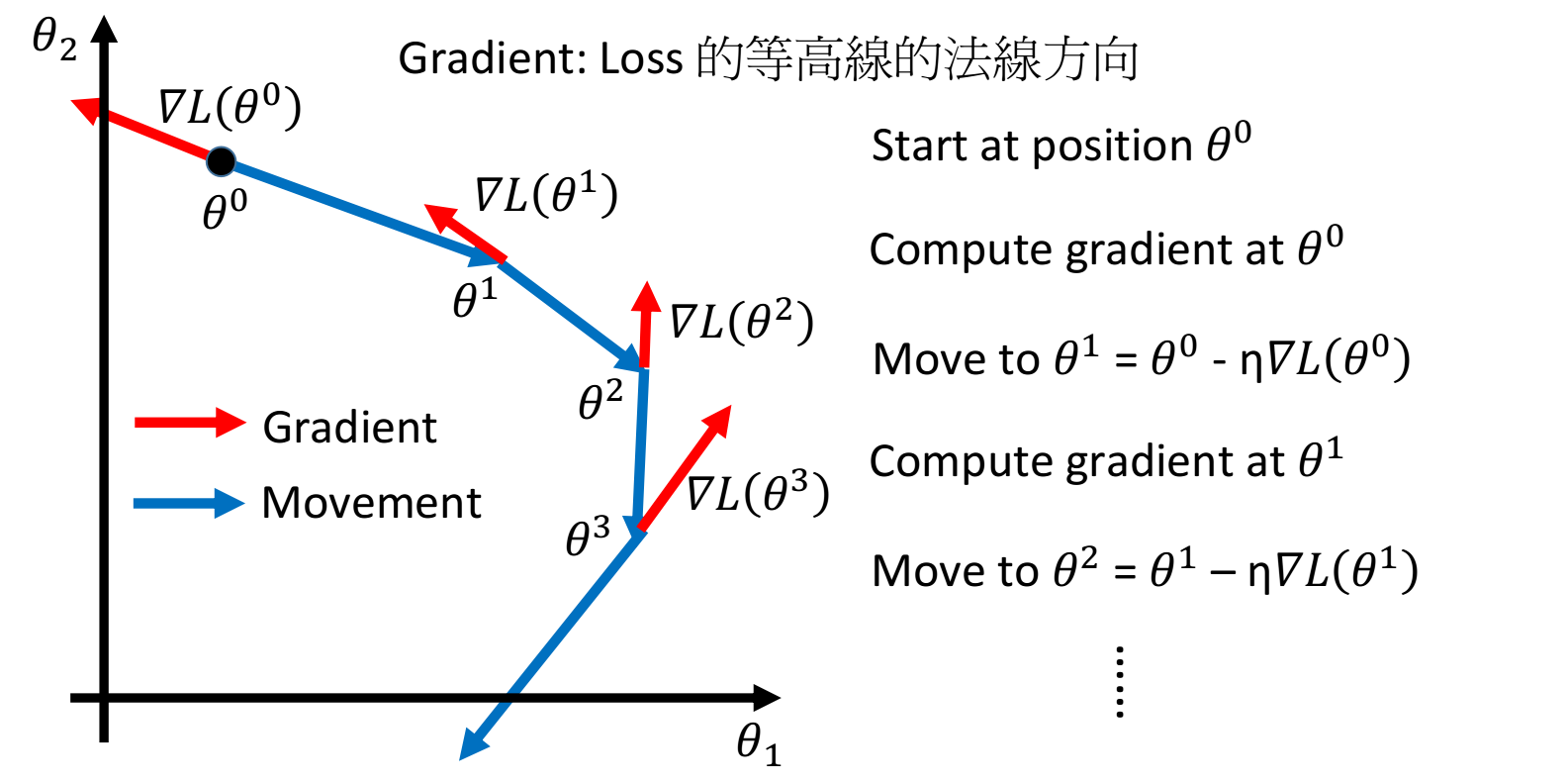

下图是将gradient descent在投影到二维坐标系中可视化的样子,图上的每一个点都是

红色箭头是指在

蓝色曲线代表实际情况下参数

因此,==在整个gradient descent的过程中,梯度不一定是递减的(红色箭头的长度可以长短不一),但是沿着梯度下降的方向,函数值loss一定是递减的,且当gradient=0时,loss下降到了局部最小值,总结:梯度下降法指的是函数值loss随梯度下降的方向减小==

初始随机在三维坐标系中选取一个点,这个三维坐标系的三个变量分别为

下面是关于gradient descent的一点思考:

Learning rate存在的问题

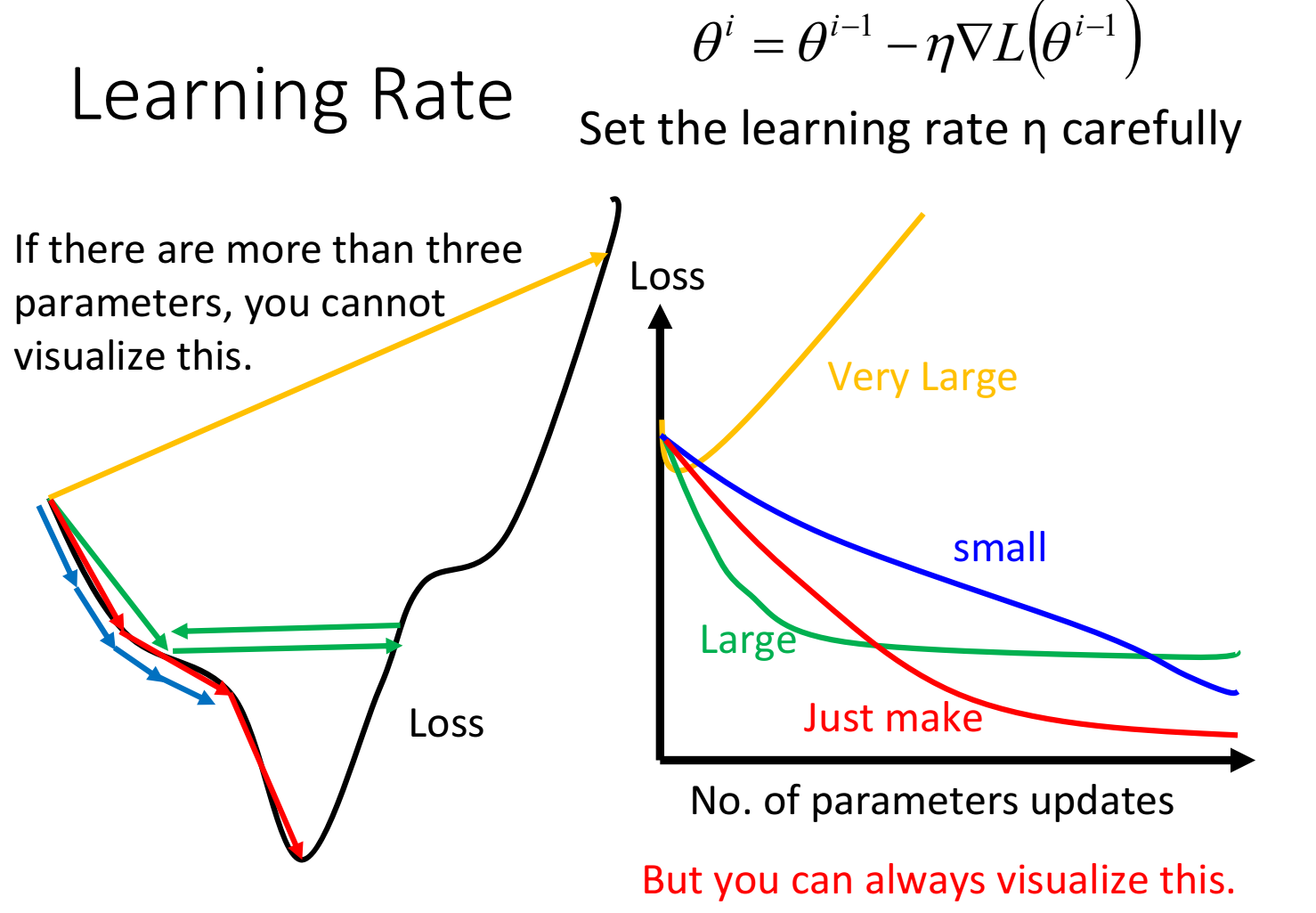

gradient descent过程中,影响结果的一个很关键的因素就是learning rate的大小

- 如果learning rate刚刚好,就可以像下图中红色线段一样顺利地到达到loss的最小值

- 如果learning rate太小的话,像下图中的蓝色线段,虽然最后能够走到local minimal的地方,但是它可能会走得非常慢,以至于你无法接受

- 如果learning rate太大,像下图中的绿色线段,它的步伐太大了,它永远没有办法走到特别低的地方,可能永远在这个“山谷”的口上振荡而无法走下去

- 如果learning rate非常大,就会像下图中的黄色线段,一瞬间就飞出去了,结果会造成update参数以后,loss反而会越来越大(这一点在上次的demo中有体会到,当lr过大的时候,每次更新loss反而会变大)

当参数有很多个的时候(>3),其实我们很难做到将loss随每个参数的变化可视化出来(因为最多只能可视化出三维的图像,也就只能可视化三维参数),但是我们可以把update的次数作为唯一的一个参数,将loss随着update的增加而变化的趋势给可视化出来(上图右半部分)

所以做gradient descent一个很重要的事情是,==要把不同的learning rate下,loss随update次数的变化曲线给可视化出来==,它可以提醒你该如何调整当前的learning rate的大小,直到出现稳定下降的曲线

Adaptive Learning rates

显然这样手动地去调整learning rates很麻烦,因此我们需要有一些自动调整learning rates的方法

最基本、最简单的大原则是:learning rate通常是随着参数的update越来越小的

因为在起始点的时候,通常是离最低点是比较远的,这时候步伐就要跨大一点;而经过几次update以后,会比较靠近目标,这时候就应该减小learning rate,让它能够收敛在最低点的地方

举例:假设到了第t次update,此时

这种方法使所有参数以同样的方式同样的learning rate进行update,而最好的状况是每个参数都给他不同的learning rate去update

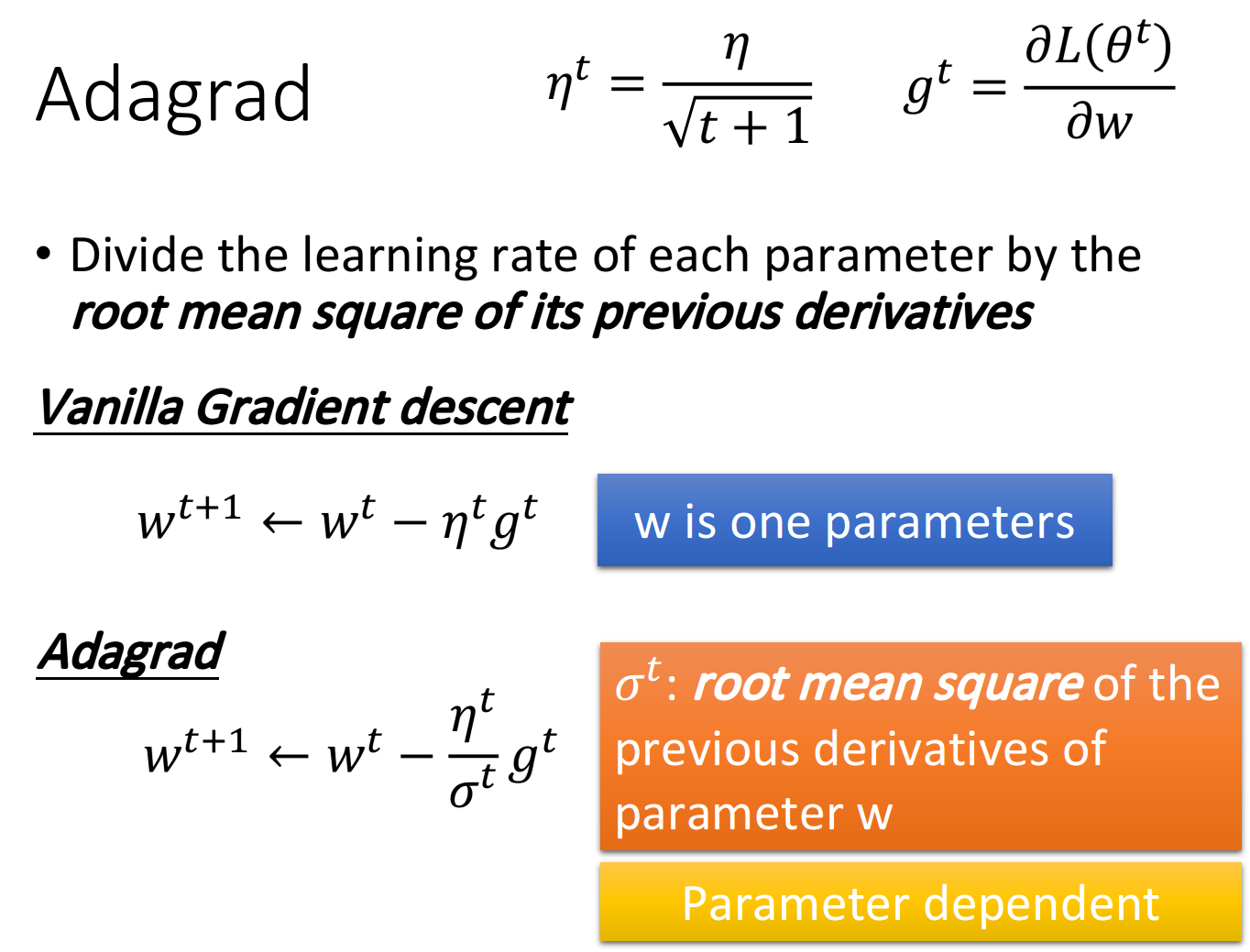

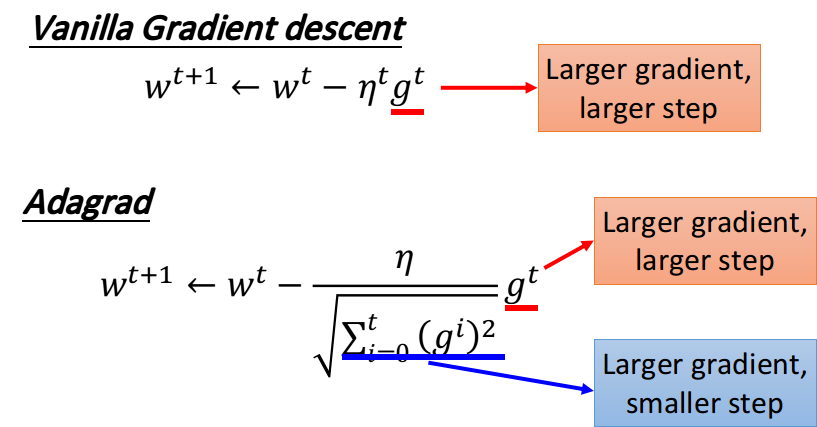

Adagrad

Divide the learning rate of each parameter by the root mean square(方均根) of its previous derivatives

Adagrad就是将不同参数的learning rate分开考虑的一种算法(adagrad算法update到后面速度会越来越慢,当然这只是adaptive算法中最简单的一种)

这里的w是function中的某个参数,t表示第t次update,

由于

Adagrad的contradiction解释

Adagrad的表达式

我们在做gradient descent的时候,希望的是当梯度值即微分值

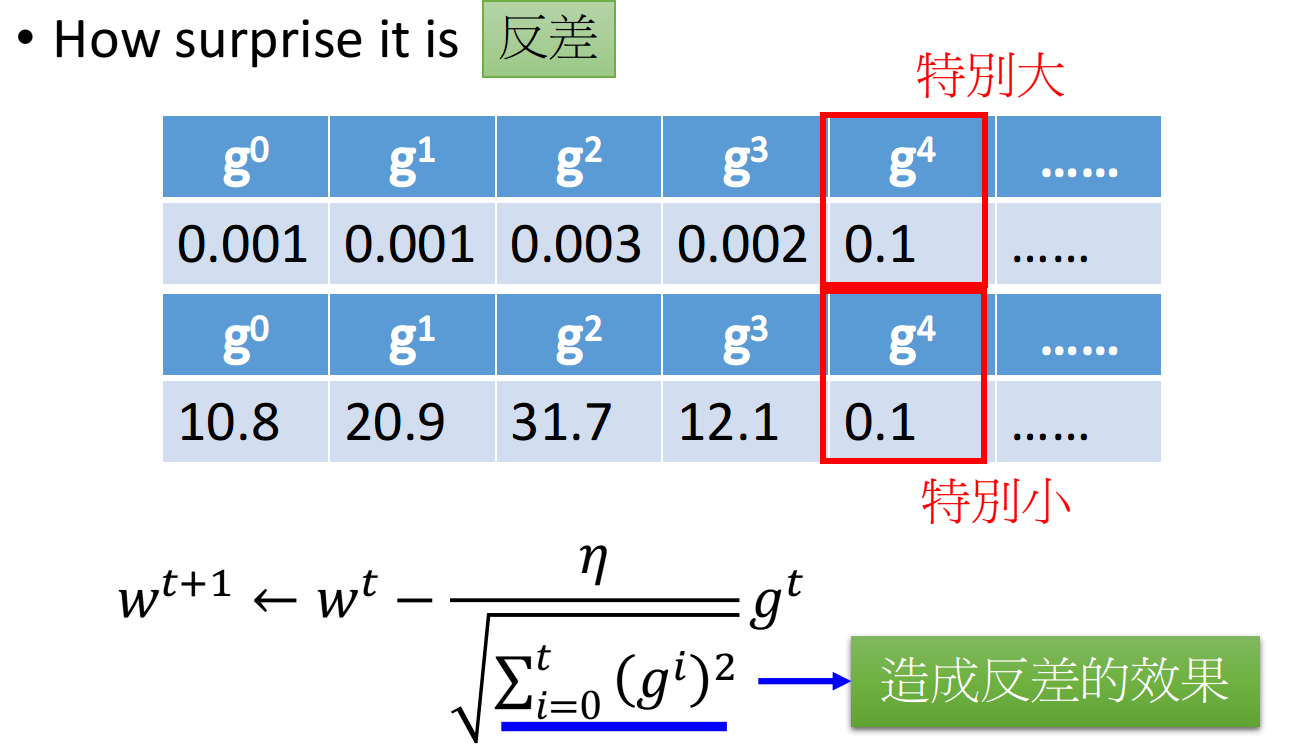

在一些paper里是这样解释的:Adagrad要考虑的是,这个gradient有多surprise,即反差有多大,假设t=4的时候

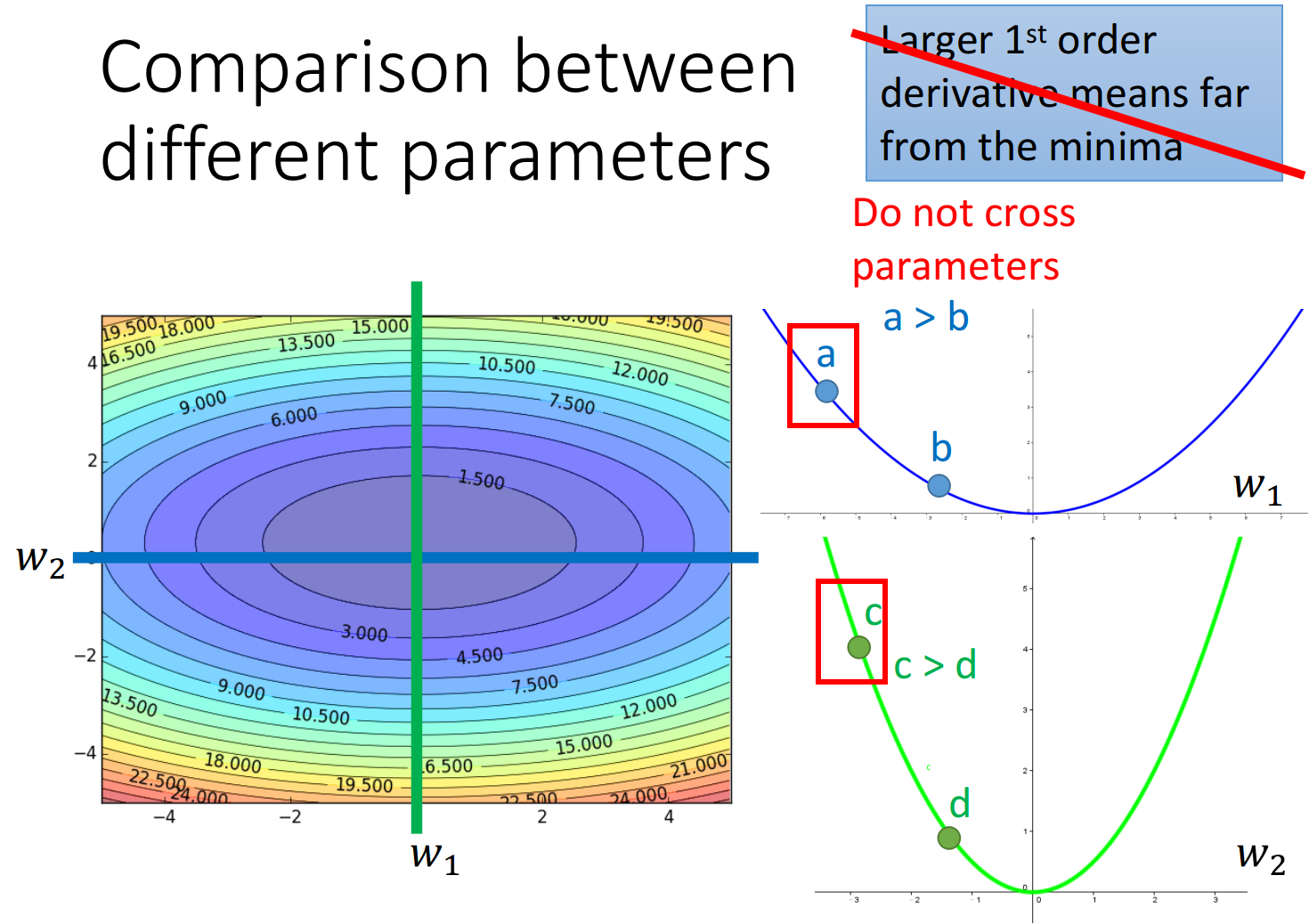

gradient越大,离最低点越远这件事情在有多个参数的情况下是不一定成立的

如下图所示,w1和w2分别是loss function的两个参数,loss的值投影到该平面中以颜色深度表示大小,分别在w2和w1处垂直切一刀(这样就只有另一个参数的gradient会变化),对应的情况为右边的两条曲线,可以看出,比起a点,c点距离最低点更近,但是它的gradient却越大

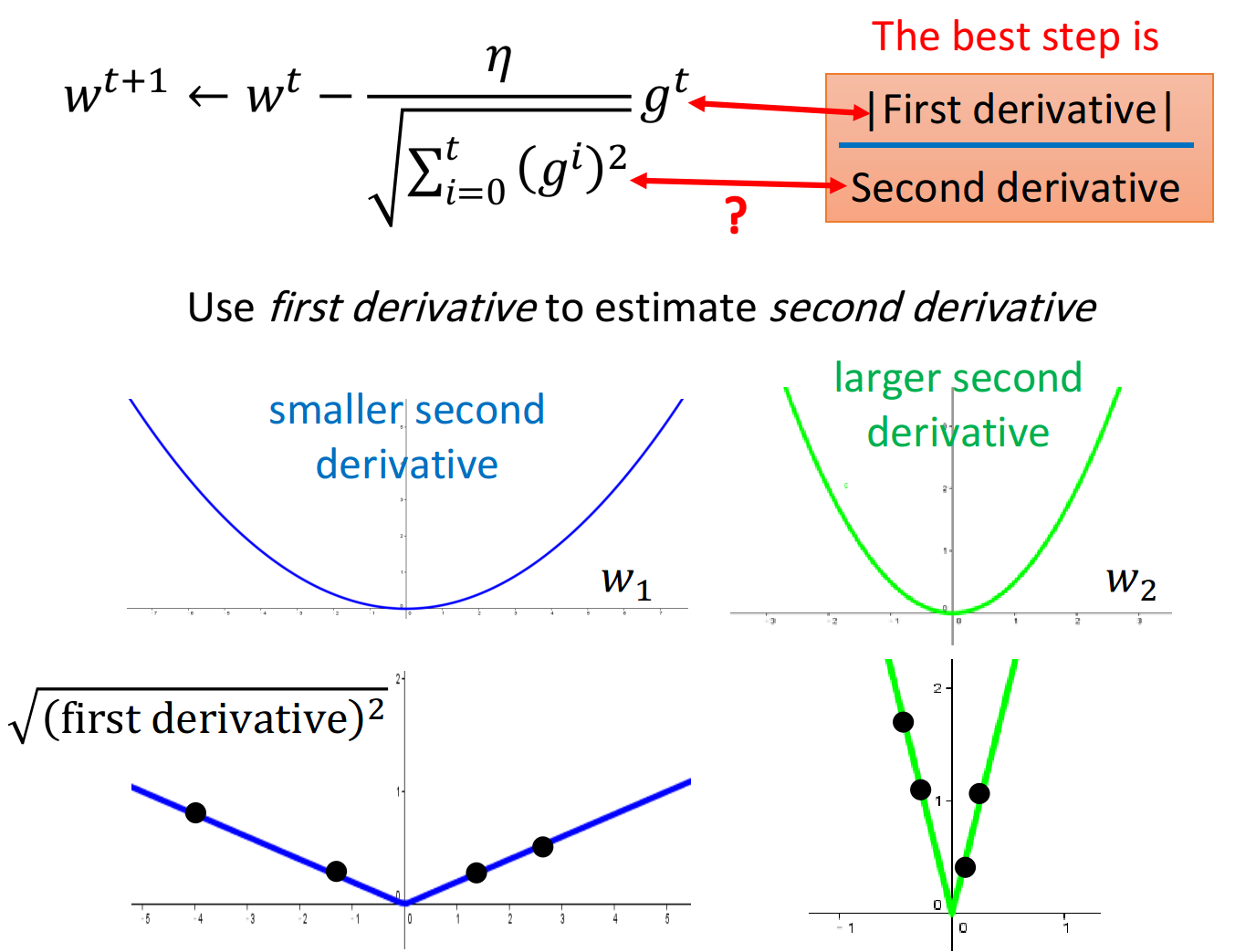

实际上,对于一个二次函数

实际上,对于一个二次函数

再来回顾Adagrad的表达式:

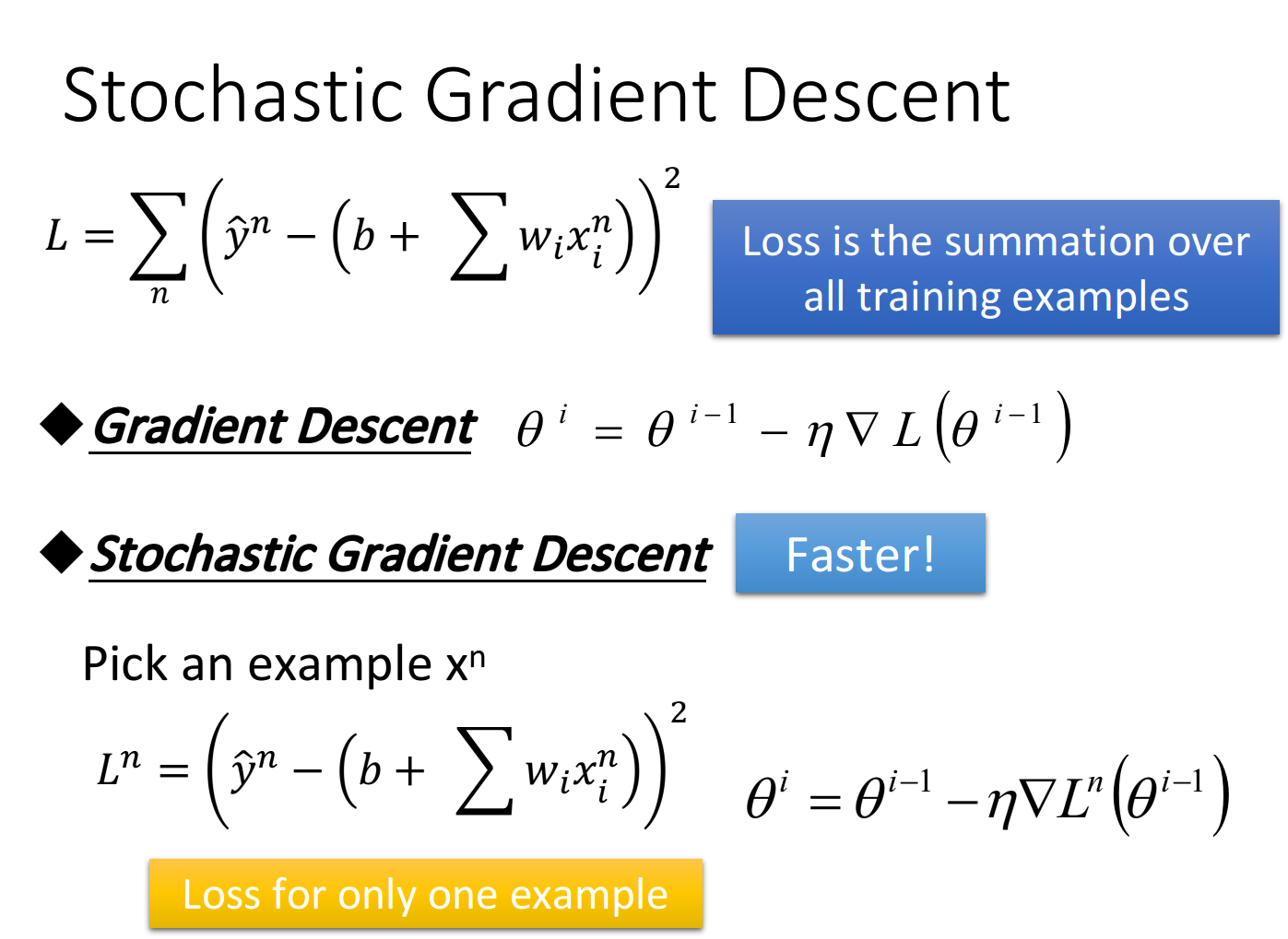

Stochastic Gradicent Descent

随机梯度下降的方法可以让训练更快速,传统的gradient descent的思路是看完所有的样本点之后再构建loss function,然后去update参数;而stochastic gradient descent的做法是,看到一个样本点就update一次,因此它的loss function不是所有样本点的error平方和,而是这个随机样本点的error平方

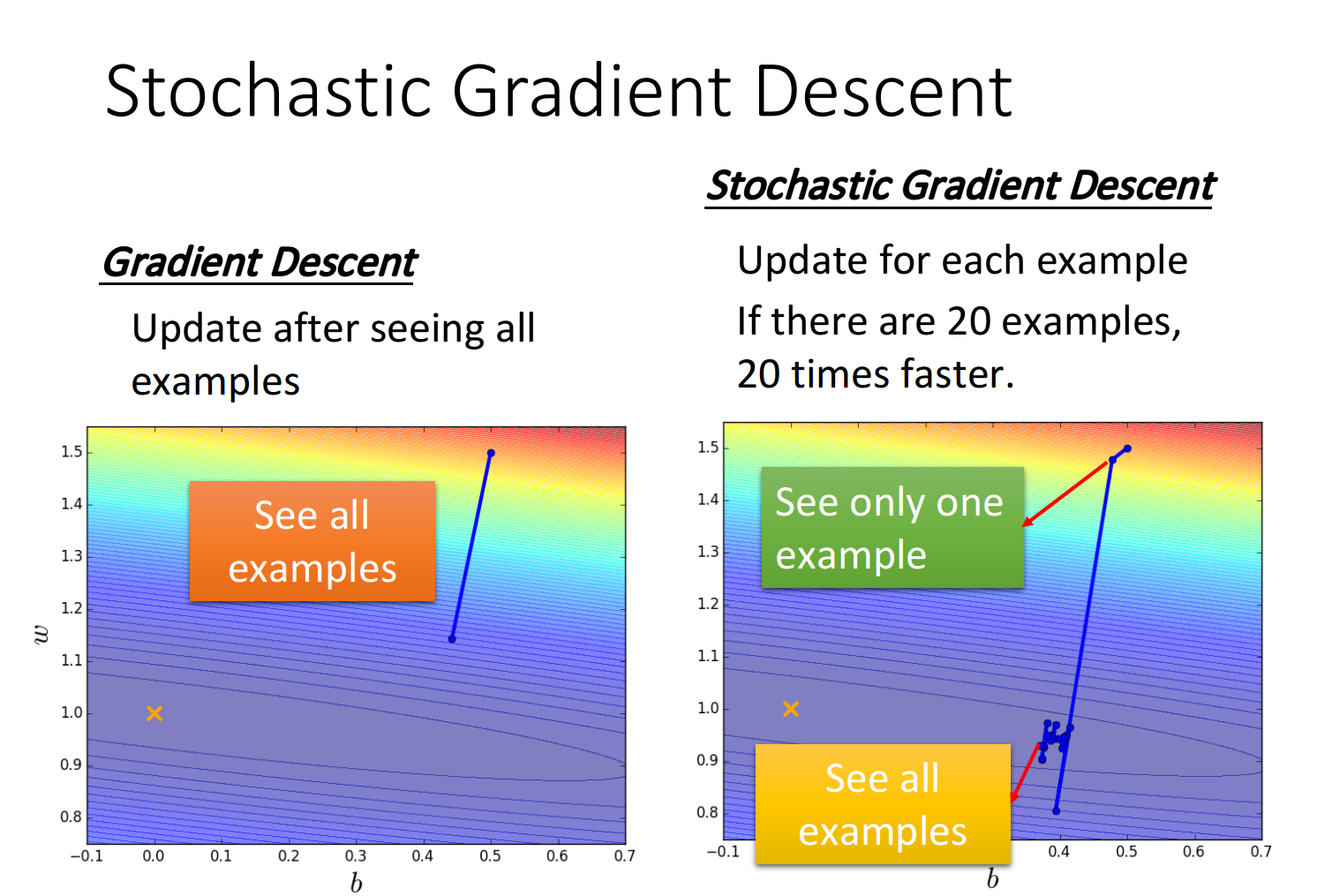

stochastic gradient descent与传统gradient descent的效果对比如下:

stochastic gradient descent与传统gradient descent的效果对比如下:

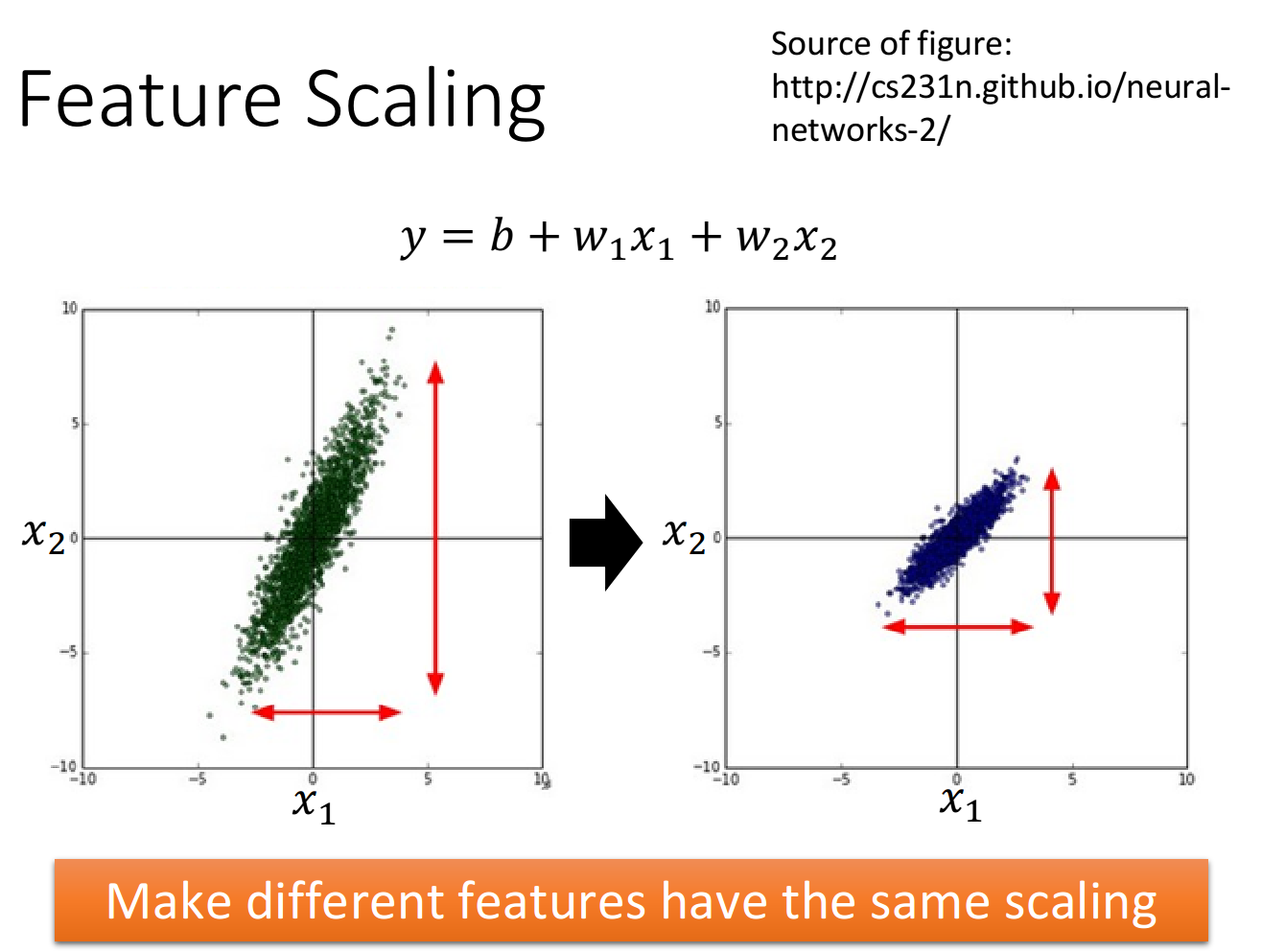

Feature Scaling

概念介绍

特征缩放,当多个特征的分布范围很不一样时,最好将这些不同feature的范围缩放成一样

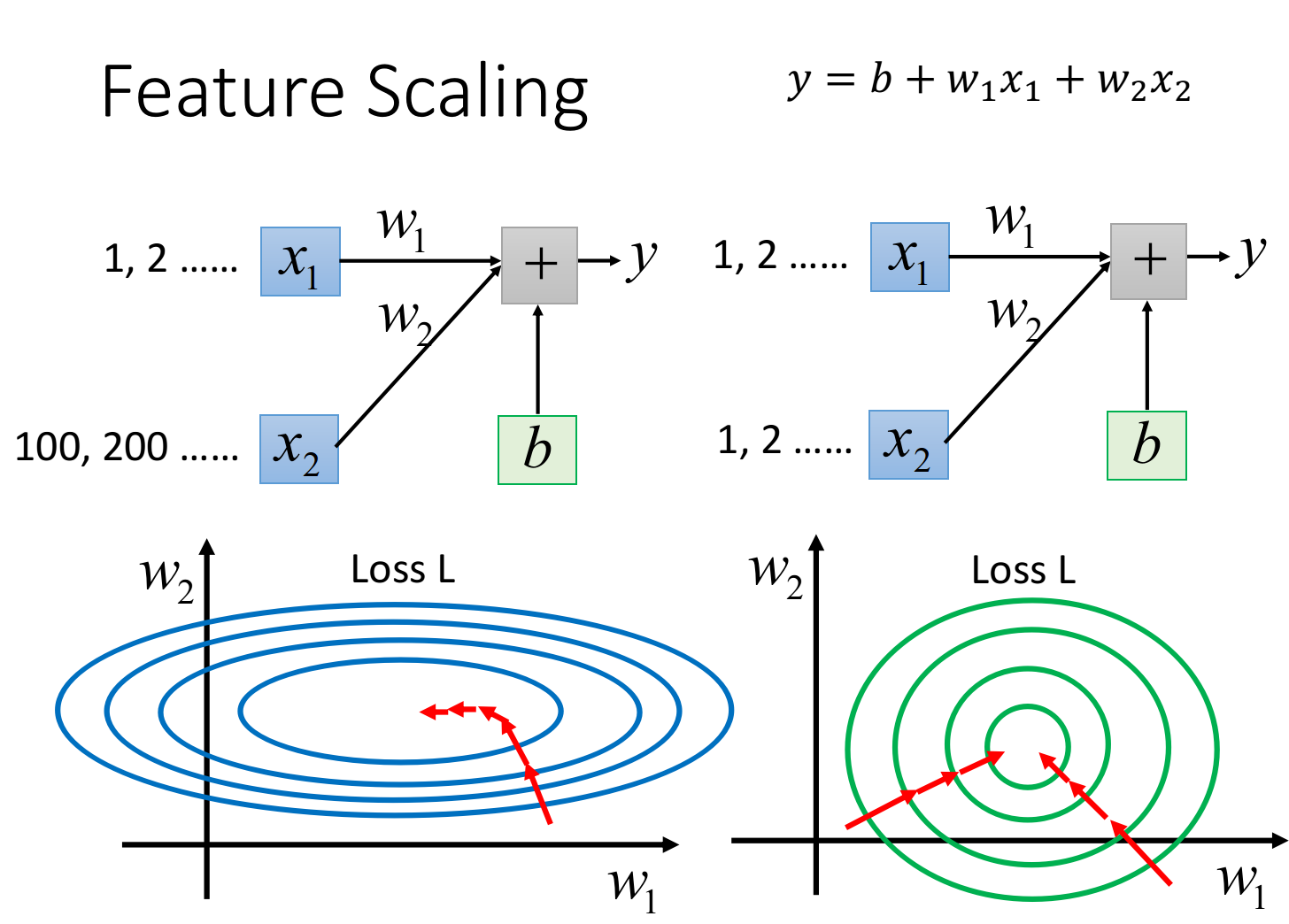

原理解释

此时去画出loss的error surface,如果对w1和w2都做一个同样的变动

左边的error surface表示,w1对y的影响比较小,所以w1对loss是有比较小的偏微分的,因此在w1的方向上图像是比较平滑的;w2对y的影响比较大,所以w2对loss的影响比较大,因此在w2的方向上图像是比较sharp的

如果x1和x2的值,它们的scale是接近的,那么w1和w2对loss就会有差不多的影响力,loss的图像接近于圆形,那这样做对gradient descent有什么好处呢?

对gradient decent的帮助

之前我们做的demo已经表明了,对于这种长椭圆形的error surface,如果不使用Adagrad之类的方法,是很难搞定它的,因为在像w1和w2这样不同的参数方向上,会需要不同的learning rate,用相同的lr很难达到最低点

如果有scale的话,loss在参数w1、w2平面上的投影就是一个正圆形,update参数会比较容易

而且gradient descent的每次update并不都是向着最低点走的,每次update的方向是顺着等高线的方向(梯度gradient下降的方向),而不是径直走向最低点;但是当经过对input的scale使loss的投影是一个正圆的话,不管在这个区域的哪一个点,它都会向着圆心走。因此feature scaling对参数update的效率是有帮助的

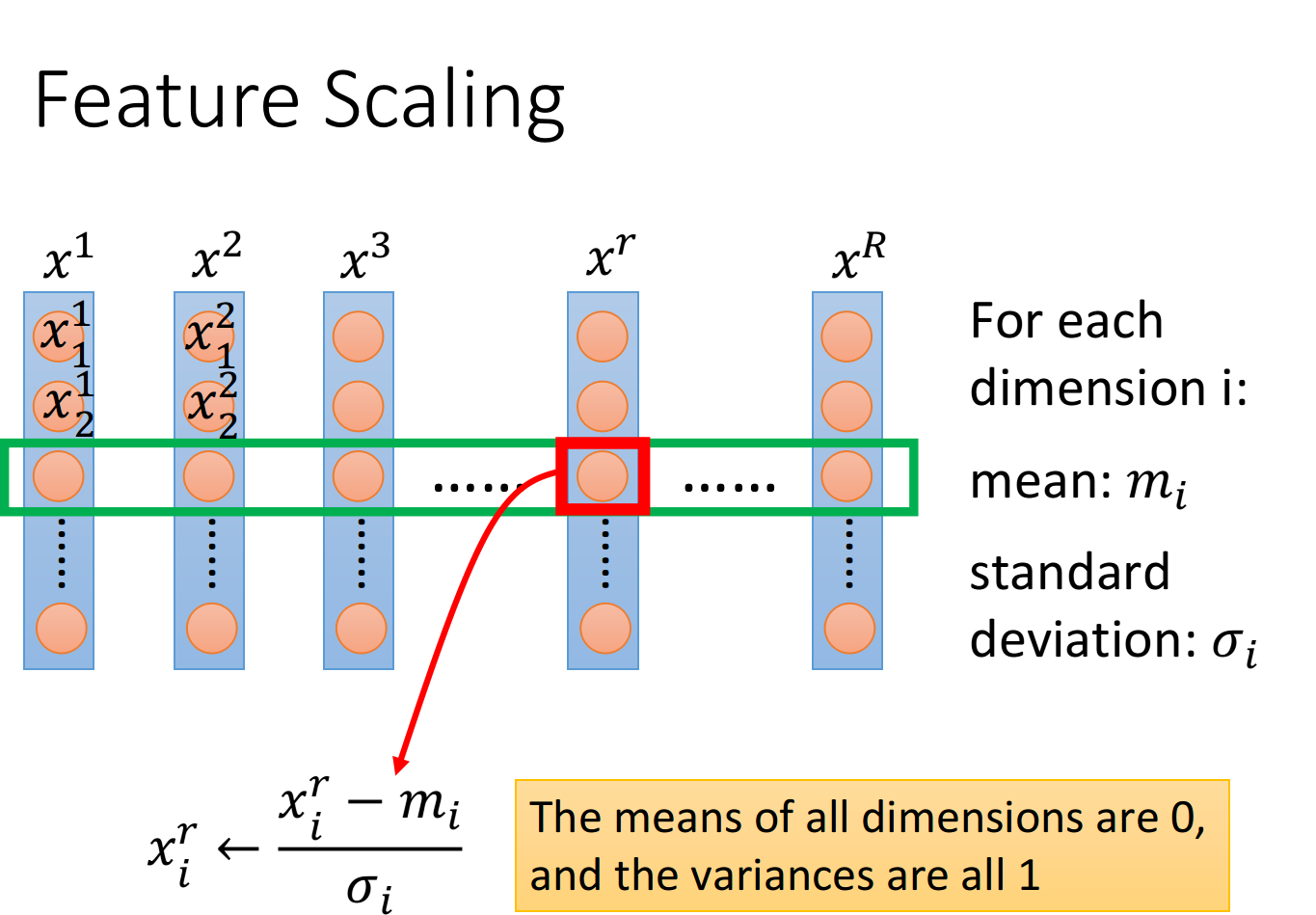

如何做feature scaling

假设有R个example(上标i表示第i个样本点),

对每一个demension i,都去算出它的平均值mean=

对第r个example的第i个component,减掉均值,除以标准差,即

说了那么多,实际上就是==将每一个参数都归一化成标准正态分布,即

Gradient Descent的理论基础

Taylor Series

泰勒表达式:

When x is close to

同理,对于二元函数,when x and y is close to

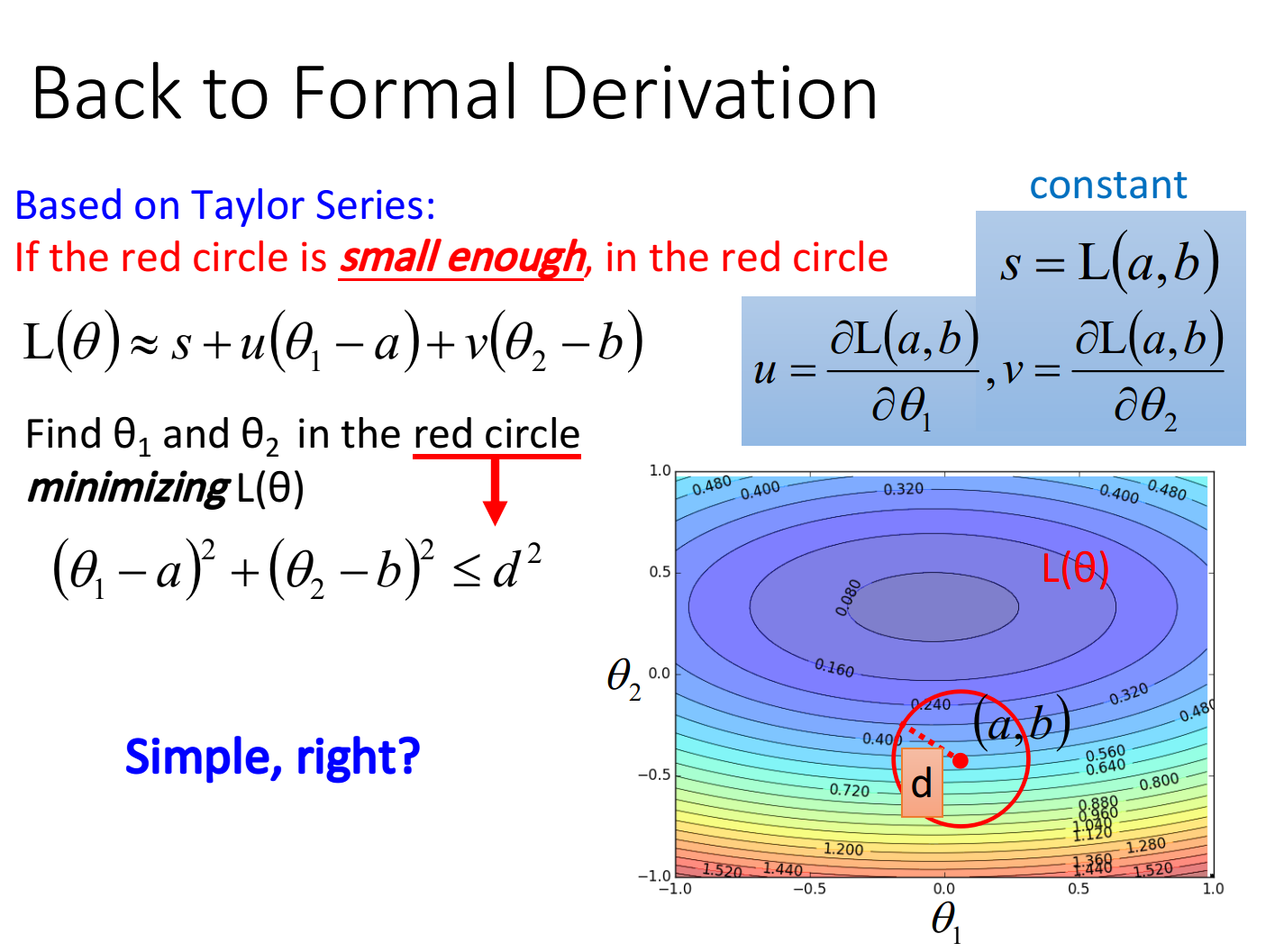

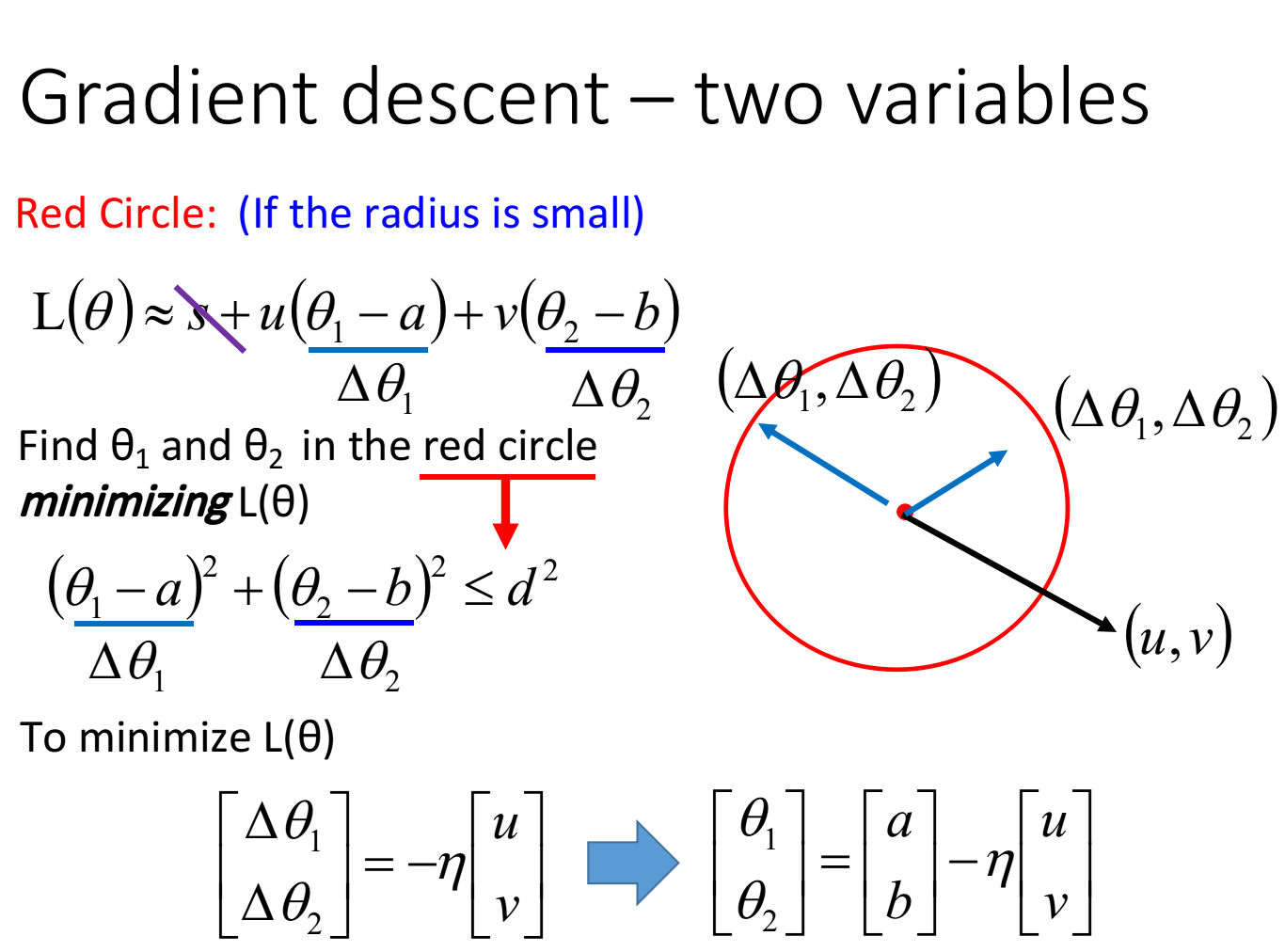

从泰勒展开式推导出gradient descent

对于loss图像上的某一个点(a,b),如果我们想要找这个点附近loss最小的点,就可以用泰勒展开的思想

假设用一个red circle限定点的范围,这个圆足够小以满足泰勒展开的精度,那么此时我们的loss function就可以化简为:

令

则

假定red circle的半径为d,则有限制条件:

此时去求

观察图形可知,当向量

这就是gradient descent在数学上的推导,注意它的重要前提是,给定的那个红色圈圈的范围要足够小,这样泰勒展开给我们的近似才会更精确,而

当然泰勒展开可以使用二阶、三阶乃至更高阶的展开,但这样会使得运算量大大增加,反而降低了运行效率

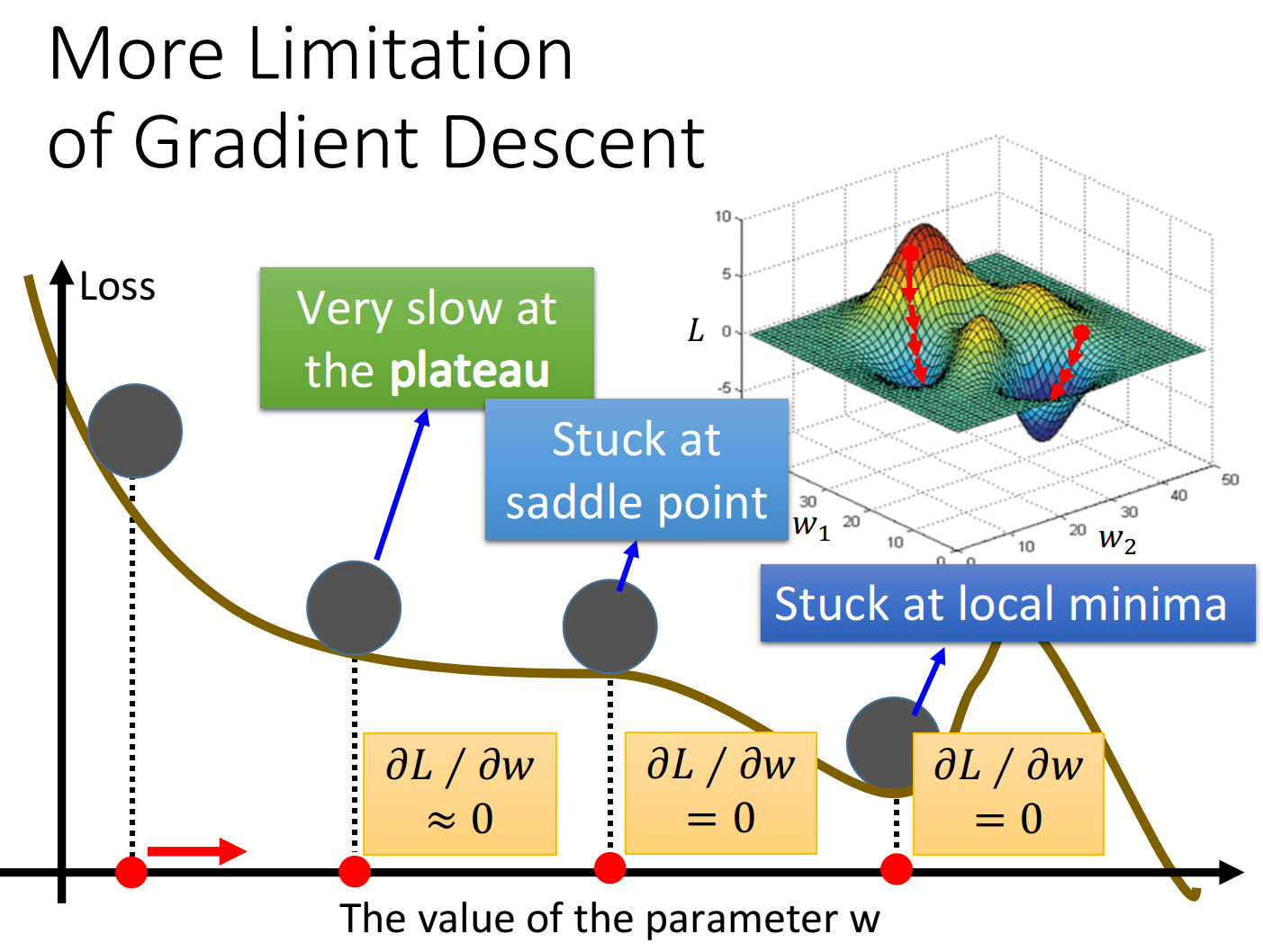

Gradient Descent的限制

之前已经讨论过,gradient descent有一个问题是它会停在local minima的地方就停止update了

事实上还有一个问题是,微分值是0的地方并不是只有local minima,settle point的微分值也是0

以上都是理论上的探讨,到了实践的时候,其实当gradient的值接近于0的时候,我们就已经把它停下来了,但是微分值很小,不见得就是很接近local minima,也有可能像下图一样在一个高原的地方

综上,==gradient descent的限制是,它在gradient即微分值接近于0的地方就会停下来,而这个地方不一定是global minima,它可能是local minima,可能是saddle point鞍点,甚至可能是一个loss很高的plateau平缓高原==